- Когда BERT был запущен в поиске Google?

- ЧтотакоеBERT?

- Что такое нейронная сеть?

- Что такое обработка естественного языка?

- Как работает BERT?

- Используется ли BERT для понимания всех запросов?

- Как BERT повлияет на мои избранные сниппеты?

- В чём разница между BERT и RankBrain?

- На какие другие продукты Google может оказывать влияние BERT?

- Можно ли оптимизировать сайт для BERT?

- Где можно узнать больше о BERT?

В октябре Google запустил крупнейшее обновление поисковых алгоритмов за последние пять лет – BERT Update. Внедрение этого алгоритма было призвано улучшить понимание запросов на естественном языке и стоящего за ними намерения. Как результат, Google теперь сможет предоставлять более релевантные результаты поиска.

BERT охватывает 10% поисковых запросов, а это значит, что он может в некоторой степени влиять на видимость и трафик в органическом поиске.

Ниже – обзор частых вопросов на тему BERT, подготовленный Search Engine Land.

Когда BERT был

запущен в поиске Google?

Запуск BERT в поисковой системе Google для запросов на английском языке был начат 21 октября 2019 года.

В будущем Google планирует расширить этот алгоритм на все языки, поддерживаемые поисковой системой, но точного графика у компании пока нет. Модель BERT также используется для улучшения блоков с ответами (featured snippets) в более чем 20 странах.

Что такое BERT?

BERT (Bidirectional Encoder Representations from

Transformers) – это метод обработки естественного языка, основанный на

использовании нейросетей новой архитектуры для работы с последовательностями,

известных как «трансформеры». Эта технология помогает Google лучше определять

контекст слов в поисковых запросах.

Например, в фразах «nine to five» (от девяти до пяти) и «a quarter to five» (без четверти пять)

предлог «to» имеет два разных значения, что очевидно для людей, но менее

понятно для поисковых систем. BERT предназначен для разграничения таких

нюансов, чтобы облегчить Google

формирование более релевантных результатов.

В ноябре 2018 года Google открыл исходный код BERT, и теперь любой может использовать эту технологию для обучения своей собственной системы обработки естественного языка — для ответов на вопросы или других задач.

Что такое нейронная

сеть?

Говоря простым языком, нейронные сети – это алгоритмы, предназначенные для выявления паттернов. Распределение изображений по категориям, распознавание рукописного текста и даже прогнозирование тенденций на финансовых рынках — это обычные области применения нейросетей. Их также используют в работе поисковых систем.

Чтобы распознавать паттерны, нейросети обучаются на наборах

данных. Предварительное обучение BERT происходило на корпусе простых текстов

из Wikipedia, о чём

Google рассказал, когда открыл исходный код технологии.

Что такое обработка

естественного языка?

Обработка естественного языка (Natural language processing, NLP) относится к области искусственного интеллекта, которая занимается лингвистикой, чтобы дать компьютерам возможность понять, как люди общаются.

К примерам достижений в области NLP можно отнести инструменты мониторинга социальных сетей, чат-боты и т.п.

В целом NLP – это не новая функция для поисковых систем. При этом BERT представляет собой прогресс в NLP, достигнутый с помощью двунаправленного обучения (подробнее об этом ниже).

Как работает BERT?

Прорывной в работе BERT является его способность обучать языковые модели на основе всего набора слов в приложении или запросе (двунаправленное обучение), тогда как в традиционном обучении анализируется упорядоченная последовательность слов (слева направо или справа налево). BERT позволяет языковой модели понимать контекст слова на основе окружающих его слов, а не только того слова, которое ему предшествует или следует сразу за ним.

Google называет BERT «глубоко двунаправленным», поскольку контекстные представления слов начинаются «с самого низа глубокой нейронной сети».

«Например, слово “bank” будет иметь одинаковое свободное от контекста представление в “bank account” (банковский счёт) и “bank of river” (берег реки). Контекстные модели вместо этого генерируют представления каждого слова, основанные на других словах в предложении. Например, в предложении «I accessed the bank account» (я получил доступ к банковскому счёту) однонаправленная контекстная модель будет представлять “bank” на основе “I accessed the”, но не “account”. При этом BERT представляет “bank”, используя и предыдущий, и следующий контекст: “I accessed the… account”».

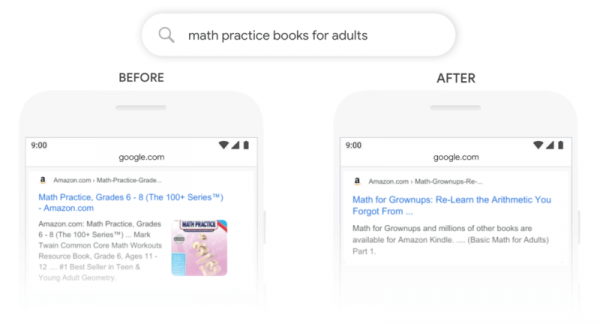

Google показал несколько примеров того, как применение BERT в поиске может влиять на результаты. Так, по запросу [math practice books for adults] (учебники по математике для взрослых) в топе поисковой выдачи раньше выводился учебник для 6-8 классов. После запуска BERT в топе SERP находится книга под названием «Math for Grownups» («Математика для взрослых»).

Учебник для 6-8 классов всё ещё выводится на первой странице

по этому запросу, но в выдаче также есть две книги, ориентированные именно на

взрослых, которые ранжируются выше, включая блок с ответом.

Изменение результатов поиска, подобное приведённому выше,

отражает новое понимание запроса с использованием BERT.

Используется ли BERT

для понимания всех запросов?

Нет. BERT помогает Google понимать 1 из 10 запросов на

английском языке в США.

«В частности, в случае более длинных, более разговорных

запросов, где предлоги, такие как “for” и “to”

имеют большое значение, поисковая система [теперь] сможет понять контекст слов

в вашем запросе», — говорится

в блоге Google.

При этом не все запросы являются разговорными или включают предлоги. Брендовые запросы и более короткие фразы – это лишь два примера тех запросов, которые не требуют применения BERT.

Как BERT повлияет на мои

избранные сниппеты?

Как мы видели на примере выше, BERT также может влиять на те

результаты, которые появляются в блоках с ответами (featured snippets или

«избранные сниппеты»).

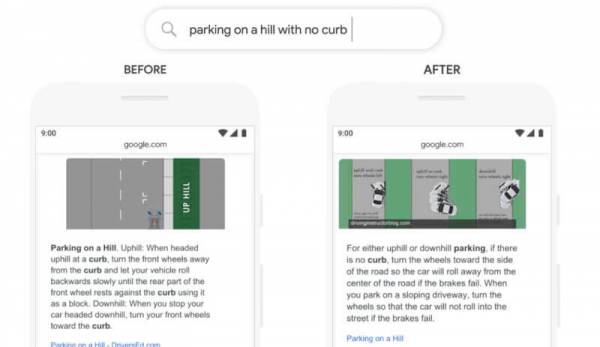

На примере ниже Google сравнивает избранные сниппеты по запросу [parking on a hill with no curb] (парковка на возвышенности без бордюра), объясняя:

«В прошлом такой запрос приводил наши системы в замешательство – мы уделяли слишком много внимания слову “curb” и игнорировали слово “no”, не понимая, несколько критичным оно было для надлежащего ответа на этот запрос. Поэтому мы возвращали результаты для парковки на возвышенности с бордюром».

В чём разница между

BERT и RankBrain?

Некоторые из возможностей BERT напоминают первый внедрённый Google метод для понимания запросов на базе ИИ – RankBrain. Но это два отдельных алгоритма, которые могут использоваться для улучшения результатов поиска.

«Первое, что нужно понять о RankBrain, — это то, что он

работает параллельно с обычными алгоритмами ранжирования в органическом поиске

и используется для корректировки результатов, рассчитанных этими алгоритмами»,

— отмечает Эрик Энж (Eric Enge), главный менеджер

Perficient Digital.

RankBrain корректирует результаты, просматривая текущий

запрос и находя похожие прошлые запросы. Затем он проверяет эффективность

результатов поиска для этих исторических запросов. «На основании того, что он

видит, RankBrain может регулировать вывод результатов обычных алгоритмов

ранжирования», — добавил Энж.

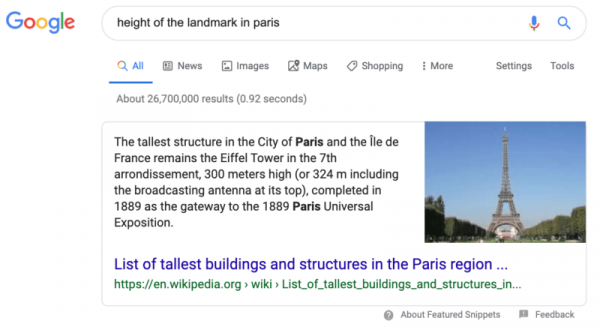

RankBrain также помогает Google интерпретировать поисковые запросы, чтобы он мог отображать результаты, которые не содержат тех слов, что есть в запросе. В приведённом ниже примере Google удалось установить, что пользователь ищет информацию об Эйфелевой башне, несмотря на то, что название башни не фигурирует в запросе [высота символа Парижа].

«BERT работает совершенно по-другому», — продолжает Энж. «Традиционные

алгоритмы пытаются анализировать контент на странице, чтобы понять, о чём он и

к чему он может относиться. При этом традиционные алгоритмы NLP, как правило, способны только

просматривать контент перед словом ИЛИ после слова для лучшего понимания

значения и релевантности этого слова. Двунаправленный компонент BERT — это то,

что его отличает».

Как упоминалось выше, BERT просматривает содержимое до и после слова, чтобы прояснить своё понимание значения и релевантности этого слова. «Это критическое улучшение в обработке естественного языка, поскольку человеческое общение по своей природе многоуровневое и сложное», — отметил Энж.

И BERT, и RankBrain используются Google для обработки запросов и содержимого веб-страниц, чтобы лучше понять, что означают используемые в них слова.

BERT

– это не замена RankBrain.

Google может использовать несколько методов для понимания запроса, а это значит,

что BERT может применяться самостоятельно, наряду с другими алгоритмами Google,

в тандеме с RankBrain, в любой комбинации или не использоваться вообще – в

зависимости от поискового запроса.

На какие другие

продукты Google может оказывать влияние BERT?

Заявление Google о запуске BERT относится только к поиску, однако это обновление также будет в какой-то мере влиять и на Assistant. Когда по запросам, выполняемым Assistant, возвращаются готовые ответы или результаты из основного поиска, то эти результаты могут подвергаться влиянию BERT.

В комментарии Search Engine Land представитель Google заявил, что в настоящее время BERT не используется для рекламы, но если он будет интегрирован в эту вертикаль в будущем, то это может помочь улучшить некоторые из неудачных близких вариантов, которые мешают рекламодателям.

Можно ли

оптимизировать сайт для BERT?

По словам евангелиста поиска Дэнни Салливана (Danny Sullivan): «Нет ничего, что можно было оптимизировать для BERT, и что следовало бы переосмыслить. Наше фундаментальное стремление вознаграждать отличный контент остаётся неизменным».

Для хорошего ранжирования Google стабильно советует фокусироваться на пользователях и создавать контент, который удовлетворяет их поисковый интент. Поскольку BERT предназначен для интерпретации этого намерения, то становится понятным, почему предоставление пользователю того, что он хочет, по-прежнему является рекомендацией Google.

«Оптимизация» теперь означает, что вы можете больше

сосредоточиться на качественном и чётко написанном контенте вместо того, чтобы

искать компромисс между созданием контента для своей аудитории и построением

линейных фраз для машин.

Где можно узнать

больше о BERT?

Ниже – небольшая подборка ссылок на те материалы, которые

можно изучить для лучшего понимания BERT. Все они на английском языке.

- Understanding searches better than ever before — Google Keyword Blog

- Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing — Google AI Blog

- BERT for question answering starting with HotpotQA — Github

- The research paper introducing BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding — Cornell University

Источник: searchengines.ru