- Истоки

- Первый апдейт (01.09.2002)

- 2003-й: обновления становятся чаще

- Февраль: Бостон

- Июль: Фриц

- Начало борьбы с некачественным контентом

- Дополнительный индекс («Supplemental Index»)

- Флорида (01.11.2003)

- Бренди (01.02.2004): появление LSI

- Подарок на Новый 2005-й год — nofollow-ссылки

- Персонализация поиска

- Jagger: борьба с некачественными ссылками

- Google local: объединение данных карт и Local Business Center

- 2007-й год: универсальный поиск

- Август 2008 года: поисковые подсказки

- Февраль 2009-го: поддержка атрибута rel="canonical"

- Декабрь 2009-го: поиск в реальном времени

- Развитие локального поиска: Google Адреса

- Кофеин (01.06.2010): работа над «свежестью» результатов

- Панда (Фермер) — новый виток борьбы с некачественными страницами

- Поддержка Schema.org и дополнительные ссылки в выдаче

- «Top Heavy»: борьба за юзабилити

- Пингвин — ужас ссылочных бирж

- DMCA Penalty: борьба с пиратским контентом

- Колибри: учет пользовательского интента

- Голубь (Pigeon): обновление локального поиска

- Преимущество сайтов с HTTPS/SSL

- «Mobile-friendly» («Mobilegeddon»)

- RankBrain (26.10.2015)

- Intrusive Interstitial Penalty: санкции за межстраничные всплывающие объявления

- Увеличение длины сниппета

- Mobile-First Index

- Медицинский апдейт (Флорида) и EAT

- Google BERT

- May 2020 Core Update

- Core Web Vitals: внедрение в 2021 году

- Движение в сторону комплексного продвижения

Борьба за качество поиска продолжается на протяжении всего развития поисковой системы Google. C 2002 года регулярно выходили обновления, которые, с одной стороны, делали поиск лучше, а с другой, усложняли жизнь оптимизаторам и владельцам сайтов, вынуждая приспосабливаться под новые условия.

Предлагаем вспомнить, как развивался поисковик №1 в мире. Ниже представлены знаковые обновления алгоритмов, которые раз за разом приводили вебмастеров в замешательство, но все же делали поиск лучше. Во всяком случае, по мнению гугломенов.

Истоки

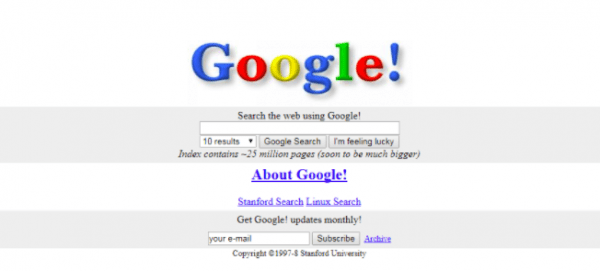

В 1996 году студенты Стэнфордского университета Ларри Пейдж и Сергей Брин начали работу над проектом BackRub, посвященным изучению ценности веб-страниц с точки зрения количества ссылающихся на них сайтов. В итоге разработали алгоритм PageRank.

Анализ поисковой выдачи на основе этого алгоритма показал более высокую релевантность результатов, чем в случае с существующими алгоритмами (на тот момент приоритет в выдаче получали страницы, на которых чаще встречалась ключевая фраза).

В 1998 году вышла статья «Анатомия системы крупномасштабного гипертекстового веб-поиска», в которой подробно описывался механизм расчета PageRank и работы новой поисковой системы Google. Поисковик, которым сегодня пользуется более 70 % населения планеты, в то время размещался на сайте Стенфорда и выглядел так:

В резюме к статье авторы написали:

«Google предназначен для эффективного сканирования и индексации интернета и обеспечения гораздо более удовлетворительных результатов поиска, чем существующие системы».

Эта философия до сих пор движет развитием поисковика. Сегодня для ранжирования документов в Google используется искусственный интеллект, а поисковая выдача стала персонализированной и зависит не только от качества, релевантности и авторитетности сайта, но и месторасположения пользователя, его интересов, образа жизни и прочих факторов.

Первый апдейт (01.09.2002)

Поначалу Google примерно 10 раз в год обновлял свои базы данных, что вызывало небольшие изменения в результатах поиска. Эти обновления в среде вебмастеров прозвали «Танец Гугла» («Google Dance»). На этот же раз изменения были намного заметней. Несмотря на то, что официального разъяснения от Google не последовало, именно это событие считается первым серьезным апдейтом алгоритма.

2003-й: обновления становятся чаще

Февраль: Бостон

Это первое официальное обновление алгоритма, представленное Google. Суть его в том, что текущие апдейты баз происходят не раз в месяц, как это было ранее, а намного чаще.

Июль: Фриц

Ежемесячный «Google Dance» окончательно уходит в прошлое — теперь Google обновляется каждый день.

Кроме этих официально подтвержденных апдейтов в 2003-м году вебмастера заметили еще несколько. Им были даны оригинальные названия:

- Кассандра (апрель) — под санкции попали сайты, на которые вели ссылки с PBN-доменов, а также страницы со скрытым текстом.

- Доминик (май) — не удалось связать этот апдейт с каким-то конкретным изменением в выдаче, но наблюдалась повышенная активность гуглоботов.

- Эсмеральда (июнь) — обновление подготовило пришествие Фрица и стало последним ежемесячным апдейтом основного алгоритма Google.

Начало борьбы с некачественным контентом

Дополнительный индекс («Supplemental Index»)

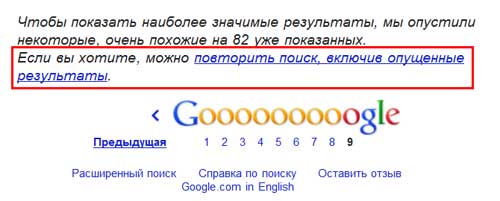

С целью повышения производительности с сентября 2003 года Google начал заносить некоторые страницы в дополнительный индекс. Это были страницы с малоинформативным, дублирующимся контентом. Они не отражались в основных результатах поиска, но Google знал об их существовании, и пользователи могли просмотреть дополнительные результаты поиска по конкретному сайту, кликнув по ссылке «Supplemental Results».

Вот как это выглядело в рунете.

В 2007 году ссылку убрали, но дополнительный индекс остался и еще долгое время вводил в заблуждение оптимизаторов. Сегодня Supplemental Index неактуален.

Флорида (01.11.2003)

Это знаковое обновление, которое серьезно повлияло на качество выдачи и сформировало новую индустрию — SEO-продвижение. Впервые в выдаче просели коммерческие сайты, которые использовали незамысловатые техники продвижения 90-х вроде размещения списков ключевых фраз на страницах сайта. С выходом этого апдейта начали массово появляться профессиональные SEO-оптимизаторы, которые отслеживали изменения алгоритмов и адаптировали сайты под новые требования.

Бренди (01.02.2004): появление LSI

Google ввел ряд изменений: расширил основной индекс, внедрил латентно-семантическое индексирование (LSI), повысил роль анкорного текста и ссылочного окружения. Благодаря LSI Google начал понимать синонимы и околотематические слова, что вывело работу с ключевыми запросами на новый уровень.

Подарок на Новый 2005-й год — nofollow-ссылки

С целью борьбы со спамными ссылками, в частности, с комментариев и форумов, Google, Yahoo и Microsoft совместно предложили использовать атрибут rel="nofollow" для ссылок, которые нужно закрыть от индексации поисковыми роботами. Что и было реализовано 1 января 2005 года.

Сегодня nofollow-ссылки не менее важны для SEO, чем dofollow, ведь они позволяют сделать ссылочный профиль естественным.

Персонализация поиска

Google и ранее персонализировал выдачу, но делал это на основе пользовательских настроек в профиле. С 1 июня 2005 года Google впервые начал использовать историю поиска для формирования выдачи на основе интересов и предпочтений. Несмотря на то, что поначалу влияние алгоритма было едва заметным, обновление дало толчок к развитию полноценного персонализированного поиска.

В этот же день Google позволил добавлять в Webmaster Tools (сегодня — Search Console) карты сайта в формате XML, что позволило ускорить и улучшить индексацию страниц.

Jagger: борьба с некачественными ссылками

С сентября по ноябрь 2005 года Google выкатил несколько обновлений, связанных со спамными ссылками, ссылочными фермами и биржами платных ссылок. Сильнее всего выдачу «тряхнуло» в октябре.

Google local: объединение данных карт и Local Business Center

Поисковик работает над тем, чтобы улучшить представление информации о местном бизнесе в локальном поиске. С этой целью в марте 2005 года он объединяет данные Google maps и Local Business Center (LBC).

2007-й год: универсальный поиск

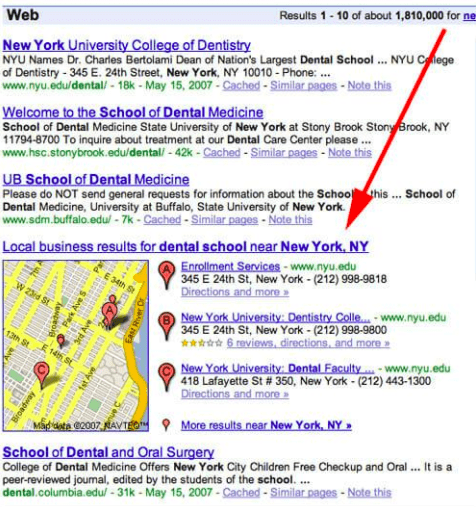

1 мая 2007 года Google в обычную выдачу начал «подмешивать» результаты из новостей, видео, карт, изображений и т. п. Таким образом, выдача стала более разнообразной. В то время результаты поиска выглядели так:

Универсальный поиск Google в 2007 году

Август 2008 года: поисковые подсказки

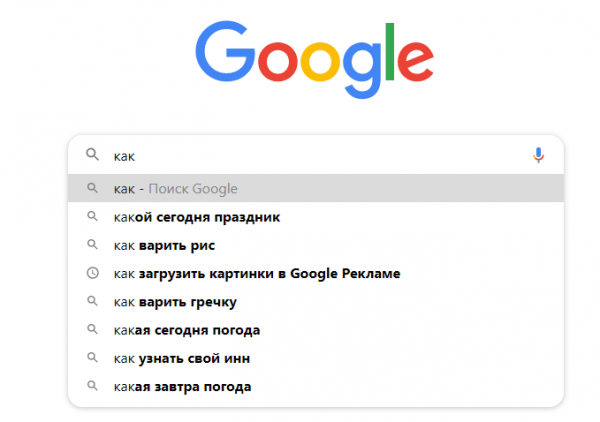

Потребовалось 4 года, чтобы протестировать и запустить инструмент Google Suggest для упрощения поиска. Пользователь начинал вводить запрос, и ему предлагался в выпадающем списке перечень связанных запросов:

Технология успешно работает по сей день, а сбор поисковых подсказок является одним из способов расширения семантического ядра сайта.

Февраль 2009-го: поддержка атрибута rel="canonical"

Google, Microsoft и Yahoo начали поддержку атрибута rel="canonical", который решает проблему дублей на сайте: страниц с разными адресами, но одинаковым содержимым. Сегодня с этим атрибутом знаком каждый SEO-специалист.

Декабрь 2009-го: поиск в реальном времени

В выдачу были интегрированы новости из Google news, актуальные твиты, посты в соцсетях, недавно проиндексированный контент. Это позволило пользователям получать свежую информацию в режиме real-time.

Развитие локального поиска: Google Адреса

Сервис Google Places с апреля 2010 года выходит из Google maps и становится самостоятельным. Результаты Адресов интегрируются в локальный поиск, появляются новые форматы местной рекламы.

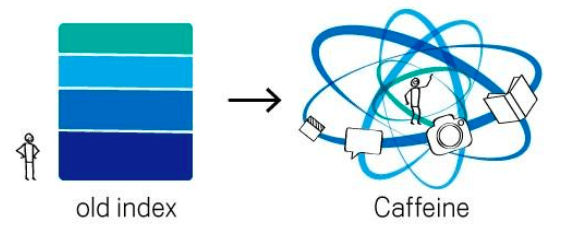

Кофеин (01.06.2010): работа над «свежестью» результатов

Это не очередное обновление алгоритма, а принципиально новая система индексации. Раньше процесс был похож на слоеный пирог, когда индексация нижних слоев была невозможна без индексации верхних. «Кофеин» изменил подход — теперь обход страницы роботом и индексация не разорваны во времени. В результате Google увеличил «свежесть» индекса на 50 %.

Принцип работы системы индексации «Кофеин»

Панда (Фермер) — новый виток борьбы с некачественными страницами

Алгоритм «Панда» был анонсирован 23.02.2011. Он появился в ответ на массовые жалобы со стороны пользователей на сайты в ТОПе с низкопробным «информационным» контентом, бесполезным по своей сути и зачастую неуникальным. «Панда» отсеивает из ТОПа подобные сайты. Отныне «штампование» статей сомнительного качества и копирование текстов с других сайтов не приводит к росту позиций.

«Панда» обновлялся почти каждый месяц вплоть до 2013 года, отсеивая новые порции сайтов. После этого было только несколько обновлений. Последнее — 17.07.2015 года («Панда 4.2», 28-е по счету).

Поддержка Schema.org и дополнительные ссылки в выдаче

2 июня 2011 года три гиганта на тогдашнем рынке поиска — Google, Yahoo и Microsoft — объявили о едином подходе к структурированным данным. Разметка Schema.org до сих пор поддерживается Google. Ее использование позволяет пользователю узнать больше информации о странице и таким образом повышает CTR сниппета в выдаче.

Внедрили микроразметку, а rich snippet все равно не отображается? Мы рассказали о возможных причинах. Проверьте свой сайт и сделайте все, что в ваших силах, чтобы исправить ситуацию.

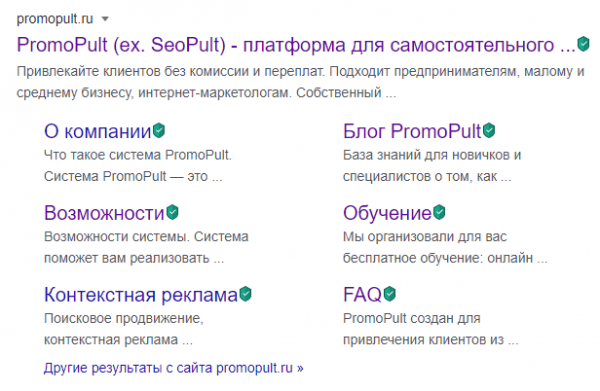

В августе 2011 года Google выкатил еще одно обновление SERP: по брендовым запросам в сниппетах появились дополнительные ссылки. Поначалу их было 12, но вскоре поисковик ограничил количество шестью.

Так выглядит сниппет с дополнительными ссылками в 2020-м.

«Top Heavy»: борьба за юзабилити

19 января 2012 года алгоритм понижает в выдаче сайты с избытком рекламы в верхней части страницы. Кроме того, реклама не должна перекрывать текст и другой контент, а также доминировать на странице. Таким образом, Google начал борьбу за повышение юзабилити сайтов.

Пингвин — ужас ссылочных бирж

24 апреля 2012 года вышел один из важнейших алгоритмов, из-за которого пострадал рынок массовой закупки ссылок для продвижения в Google. «Пингвин» создан для борьбы с манипуляцией выдачей с помощью спамных техник (ссылки с неестественными анкорами, «ссылочный взрыв», переспам текстов ключевыми запросами и т. п.). В анонсе алгоритма указано:

«Мы хотим, чтобы люди занимались «белой» поисковой оптимизацией (или вовсе ею не занимались) и могли сосредоточиться на создании привлекательных веб-сайтов».

Посыл вполне ясный: SEO — это меры, направленные на улучшение сайта, но не на поиск уязвимостей Google. Чтобы не попасть под очередное обновление «Пингвина», рекомендовалось разнообразить внешний ссылочный профиль: разбавить анкоры, добавить nofollow-ссылки и естественные ссылки с авторитетных доноров, постепенно снимать ссылки с нетематических сайтов, изменить вхождение ключей и т. п.

«Пингвин» обновлялся примерно раз в год. Последний раз — 27.09 и 06.10.2016 года (Penguin 4.0, Phase 1 и 2). В этот раз алгоритм не понижает сайты в выдаче, а просто не учитывает вес, передаваемый «плохими» ссылками. Иными словами, они становятся бесполезными, и сайт естественным путем теряет позиции.

Апдейтов «Пингвина» больше не будет — он становится частью основного поискового алгоритма и работает в непрерывном режиме.

Как узнать, что Google применил санкции к вашему сайту? Мы рассказали о 7 способах проверки на фильтры поисковых систем.

DMCA Penalty: борьба с пиратским контентом

Для борьбы с пиратством Google 10 августа 2012 года запустил алгоритм «DMCA Penalty», или «Pirate». Так как стало поступать много жалоб на его неэффективную работу, 21 октября 2014 года вышло обновление — «Pirate 2.0».

Проседание позиций было существенным — некоторые сайты теряли до 98% видимости. «Pirate 2.0» выбирает сайты для пессимизации путем анализа семантики на предмет наличия «пиратских» запросов (например, «скачать музыку бесплатно», «фильмы торренты скачать» и т. п.), а также учитывает жалобы от правообладателей в DMCA.

В 2020 году в выдаче Google по подобным запросам можно увидеть уведомление о скрытых результатах:

Колибри: учет пользовательского интента

В Google выявили, что запросы становятся все более «разговорными». Например, когда пользователь вводит запрос «какова высота Эвереста», он хочет получить конкретный ответ, а не найти страницу, на которой есть такой же вопрос. Для того чтобы Google понимал не только контекст вводимого запроса, но и пользовательский интент (намерение), в августе 2013 года запустили алгоритм «Колибри». Это масштабное обновление, которое затронуло 90% всех результатов поиска.

Голубь (Pigeon): обновление локального поиска

Алгоритм был анонсирован 24 июля 2014 года. Основная его направленность — улучшение выдачи по запросам, связанным с местоположением. Результатом обновления стала ротация сайтов в местной выдаче в зависимости от местоположения пользователя в момент запроса.

Преимущество сайтов с HTTPS/SSL

С 6 августа 2014 года сайты с SSL-сертификатами получают незначительное преимущество в выдаче. Интернет-магазины и прочие сайты, которые имеют дело с личными данными пользователей и онлайн-платежами, начали массовую миграцию на HTTPS.

В блоге PromoPult есть подробная инструкция по переходу на протокол HTTPS.

«Mobile-friendly» («Mobilegeddon»)

С апреля 2015 года в мобильной выдаче Google при прочих равных условиях приоритет отдается результатам, оптимизированным для просмотра на мобильных устройствах.

Для проверки мобилопригодности пройдите Mobile-Friendly Test. Если с сайтом есть проблемы, появится соответствующее сообщение с перечнем ошибок.

В мае 2016 года вышло обновление алгоритма — Mobile-Friendly 2.

RankBrain (26.10.2015)

RankBrain — это часть основного поискового алгоритма Google, работающая на принципах машинного обучения. Новый алгоритм создан для эффективного поиска релевантных страниц по поисковым запросам. Для SEO это означает бесповоротный уход от спамных техник в сторону создания качественных площадок и контента, который интересен целевой аудитории.

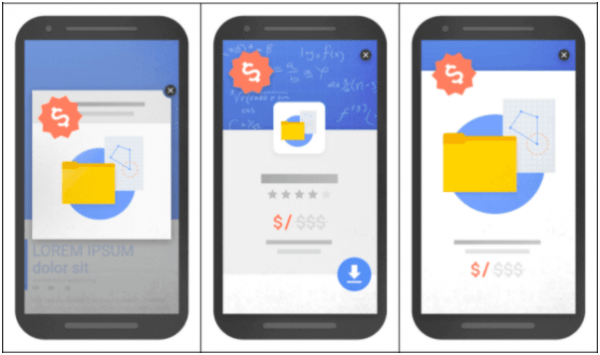

Intrusive Interstitial Penalty: санкции за межстраничные всплывающие объявления

С января 2017 года Google начал понижать позиции сайтов, которые показывают назойливые объявления, перекрывающие основной контент. Алгоритм касается:

- только мобильной выдачи и не затрагивает десктопную;

- сайтов, которые показывают объявления сразу после перехода пользователя из поисковой системы (то есть за объявления при переходе между страницами сайта санкций не будет).

Примеры назойливых объявлений

Увеличение длины сниппета

После почти двухлетнего тестирования длинных сниппетов в ноябре 2017 года Google увеличил длину описания почти в 2 раза — примерно до 300 символов. Через некоторое время (в мае 2018 года) поисковик отказался от этого эксперимента, но не во всех случаях.

Подробнее о длине description и о том, как часто Google игнорирует содержимое этого метатега, читайте в исследовании.

Mobile-First Index

После тестирования в течение многих месяцев 26 марта 2018 г. наконец было объявлено о внедрении Mobile-First Index. Наличие и работоспособность мобильной версии сайта отныне стало одним из важных факторов ранжирования в Google. Вебмастера стали получать уведомления в Google Search Console о том, что их сайты переведены на приоритетное мобильное индексирование.

С сентября 2020 года Google планировал применить Mobile-First ко всем сайтам. В связи с пандемией COVID-19 внедрение перенесено на март 2021 года.

Изучите руководство по Mobile First: часть 1, часть 2, часть 3.

Медицинский апдейт (Флорида) и EAT

С 2018 года Google регулярно анонсирует core updates — апдейты основного («корневого») алгоритма. Первым в этом ряду стал так называемый медицинский апдейт, который затронул сайты с контентом на медицинскую тематику и YMYL-сайты (Your Money Your Life): ecommerce, финансы, кредиты и т.д. Наибольший «шторм» в выдаче наблюдался 1 — 2 августа 2018 года.

Поисковик начинает оценивать сайты, которые влияют на здоровье, жизнь и финансовое состояние человека, по строгим критериям качества. На таких ресурсах должна быть достоверная информация из авторитетных источников.

Следующие апдейты основного алгоритма Google с сентября 2018 по сентябрь 2019 года в основном касались факторов, которые объединяют в аббревиатуру E-A-T, где:

- E (expertise) означает экспертный уровень автора контента. Все темы, которые касаются здоровья и благополучия пользователей, должны освещать специалисты в соответствующих областях.

- A (authoritativeness) означает авторитетность автора или сайта в целом. Измеряется в цитируемости материалов конкретного эксперта или ресурса.

- T (trustworthiness) означает надежность сайта. Ресурс должен вызывать доверие посетителей за счет качественного контента, указания полной контактной информации, а также информации об оплате, доставке и гарантиях, если это необходимо.

С 2019 года для YMYL-сайтов началась новая эпоха. Чтобы выйти из-под апдейта алгоритма или не попасть под него, нужно позаботиться об авторитетном экспертном контенте.

Google BERT

22 октября 2019 Google анонсировал обновление алгоритма BERT (Bidirectional Encoder Representations from Transformers — двунаправленная нейронная сеть кодировщик). Суть обновления в том, что алгоритм на основе нейронной сети лучше понимает фразы на естественном языке. Этим поисковик заявляет о новом подходе к формированию выдачи на основе смысла запроса, а не значения конкретных ключевых слов. Учитываются: порядок слов, предлоги, контекст, интент запроса.

May 2020 Core Update

Обновление алгоритма было запущено 4 мая 2020 года и повлияло на сайты YMYL-тематики, а также некоторые другие сферы. Среди изменений в выдаче было замечено:

- более частое появление ссылок из соцсетей в SERP;

- монополизация выдачи крупными порталами, даже по средне- и низкочастотным запросам.

Как и всегда, представители Google довольно сдержанно комментируют суть обновлений. Чтобы проверить, соответствует ли сайт критериям качества, изучите асессорскую инструкцию Google и уделите внимание E-A-T-факторам.

Core Web Vitals: внедрение в 2021 году

Летом 2020 года Google анонсировал Core Web Vitals — комплекс факторов, которые определяют качество ресурса. Под этим же названием поисковик планирует объединить сервисы, которыми можно проверить производительность сайта, в один общий: Lighthouse, Chrome DevTools, PageSpeed Insights и Search Console’s Speed Report.

Ядро Core Web Vitals (CWV) составляют три фактора:

- Largest Contentful Paint (LCP) — время отрисовки браузером основного контента на странице в видимой области просмотра.

- First Input Delay (FID) — время ответа сервера после первого взаимодействия со страницей.

- Cumulative Layout Shift (CLS) — показатель смещения элементов на странице в процессе ее загрузки. Здесь важно обратить внимание, есть ли на странице рекламные блоки, которые сдвигают основной контент по мере загрузки и таким образом делают его менее доступным для пользователя.

Совокупность этих показателей говорит о качестве сайта и степени удовлетворенности пользователя от взаимодействия с ним.

CWV планируется полноценно внедрить в 2021 году.

Движение в сторону комплексного продвижения

Историю алгоритмов Google полезно знать не просто ради общего развития. Она дает понимание того, куда движется поисковая оптимизация. Современное SEO давно вышло за пределы чисто ссылочной или текстовой оптимизации — важна работа над комплексом внутренних и внешних факторов, иногда даже напрямую не связанных с вебом. Таких, например, как репутация бренда или специалиста.

Именно поэтому PromoPult развивается в сторону комплексного маркетинга, автоматизируя работу с разными инструментами продвижения. Поисковая оптимизация сайта, контекстная реклама, реклама в соцсетях, управление репутацией, повышение конверсии на сайте доступны для всех зарегистрированных пользователей PromoPult.

Источник: blog.promopult.ru