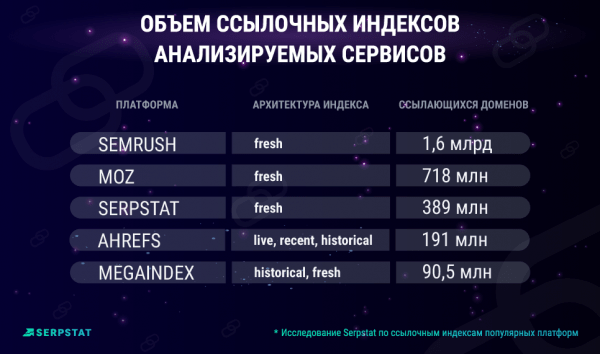

Объем ссылочного индекса, а именно количество доменов и страниц, ссылающихся на сайт, в базе данных определенного сервиса, принято считать одним из ключевых показателей при выборе инструмента для построения беклинков. Однако количество не всегда говорит о качестве. Недавнее исследование Serpstat наглядно показало, что большинство маркетологов продолжает тратить свои рекламные бюджеты впустую, переплачивая за мусор в отчетах (дубли, спамные и устаревшие ссылки).

Компания проанализировала ссылочные индексы наиболее популярных платформ:

- ahrefs.com

- moz.com

- megaindex.ru

- semrush.com

- majestic.com

- serpstat.com

Для качественной и количественной оценки SEO-сервисов использовались следующие параметры:

- объем ссылочного индекса;

- частота и скорость обновления данных;

- индекс покрытия;

- уникальность данных по ссылкам.

Чтобы обеспечить максимальную точность и объективность результатов, аналитики Serpstat рандомно выбрали для исследования 10 доменов, которые относятся к разным нишам, имеют различную географию и объем трафика.

Полученные инсайты позволяют по-новому взглянуть на процесс линкбилдинга.

Ключевые различия и объем ссылочных индексов разных платформ

Внушительные объемы базы данных могут радовать глаз при формировании отчетов, однако что скрывается за красивыми цифрами? Архитектуру ссылочного индекса SEO-сервисов могут составлять разные типы ссылок:

- Fresh links. Это ссылки, которые были определены как активные при последней проверке. Подобная ссылочная масса считается наиболее точной, так как исключает устаревшую информацию, которую пользователи не используют.

- Live links. Это ссылки, которые остаются «живыми» в период с последней проверки до краулинга. Их включает в свой ссылочный индекс сервис Ahrefs.

- Recent links. Включают активные и потерянные в силу технических причин ссылки, которые имели live статус в течение последних 3-4 месяцев. Подобный субиндекс дополняет архитектуру сервиса Ahrefs.

- Historical links. Все исторические ссылки (независимо от их актуальности), которые имел домен с момента запуска ссылочного индекса. Так, Ahrefs хранит информацию по беклинкам с 2016 года, MegaIndex – с 2015 года, Majestic – за все время существования анализируемого домена.

В результате проведенных исследований были получены следующие данные по объему ссылочных индексов для каждого сервиса:

- Semrush – 1.6 млрд.

- MOZ – 718 млн.

- Serpstat – 389 млн.

- Ahrefs – 191 млн.

- MegaIndex – 90,5 млн.

Различия в цифрах вызваны особенностями не только архитектуры ссылочных индексов, но и алгоритмов работы поисковых роботов платформ:

- частотой и временем обновления базы данных;

- возможностью сервиса находить новые ссылки и скоростью поиска;

- способностью удалять неактуальные данные и временем, необходимым для этого процесса;

- особенностями краула: учет тегов noindex/nofollow, meta robots и других, различных типов блокировки страниц, т.д.

Вывод: за огромным объемом базы данных нередко стоит неактуальная информация, которая не несет реальной пользы. Дубли, спамные и устаревшие ссылки могут составлять ядро ссылочного индекса, что делает количественные показатели исключительно маркетинговой уловкой.

Частота обновления данных

Анализируемые сервисы имеют свой собственный заявленный цикл обновления данных о ссылках, который варьируется от 60 до 180 дней:

- Semrush – 6 месяцев;

- Majestic – от 90 до 120 дней;

- MOZ – 90 дней;

- Ahrefs – 90 дней;

- MegaIndex – 90 дней;

- Serpstat – 70 дней.

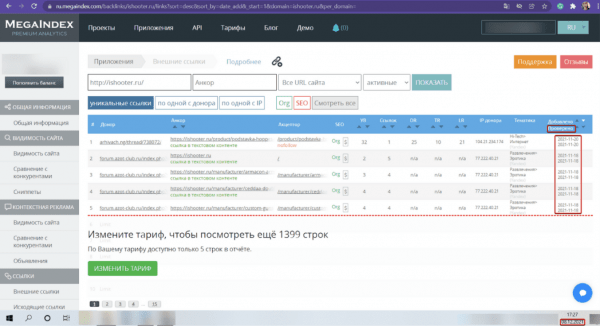

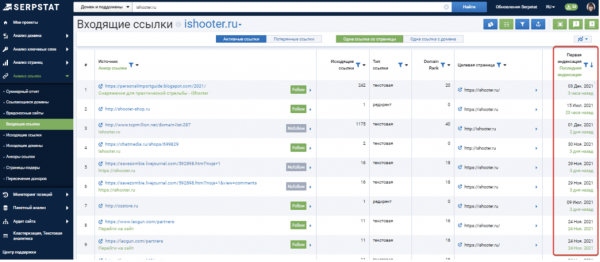

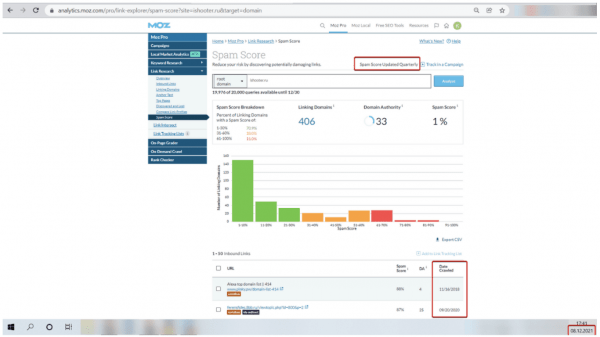

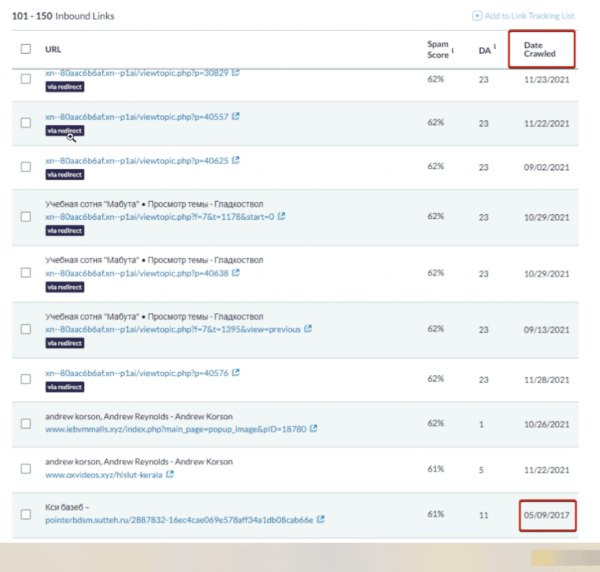

Тем не менее, в рамках анализа компания Serpstat выяснила, что при реальной проверке некоторые сервисы включают в отчеты данные, которые не соответствуют указанной частоте обновления.

MegaIndex

Serpstat

MOZ

Большинство опрошенных Serpstat экспертов сходятся во мнении, что оптимальной частотой обновления данных в индексе является интервал от нескольких дней до пары месяцев, а качество полученных ссылок гораздо важнее количества, ведь имеют значение только те беклинки, которые учитываются поисковыми системами для оценки сайта.

Индекс покрытия

В среднем сервисы показывают от 30% до 70% от всех существующих ссылок. В большинстве случаев для работы с ссылочным профилем данной информации достаточно. Тем не менее, в отдельных ситуациях, например, при выводе сайта из-под алгоритмических фильтров, очень важно иметь максимально полную картину. Здесь и имеет значение индекс покрытия ссылок анализируемых платформ.

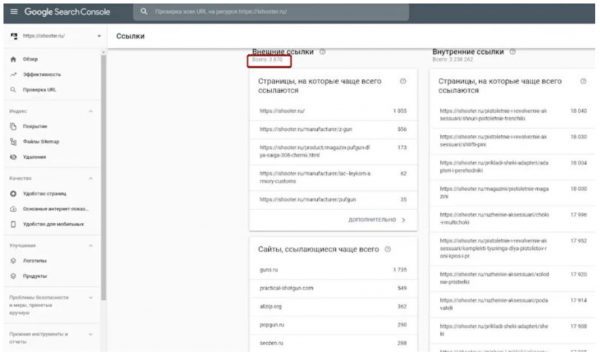

Так как определить фактическое количество ссылок невозможно, компания Serpstat использовала в качестве контрольного параметра информацию о ссылках из Google Search Console, как из независимого источника.

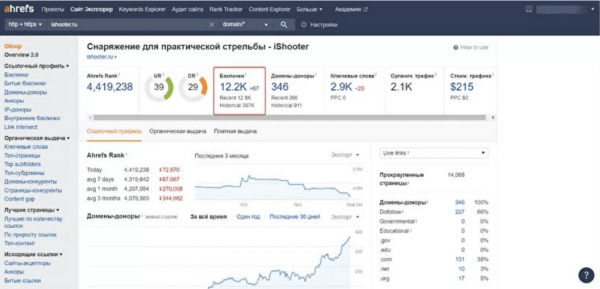

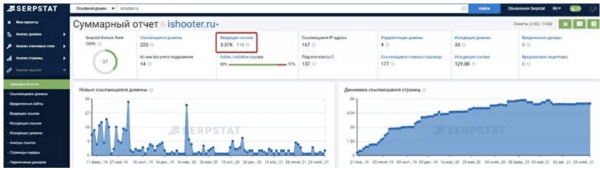

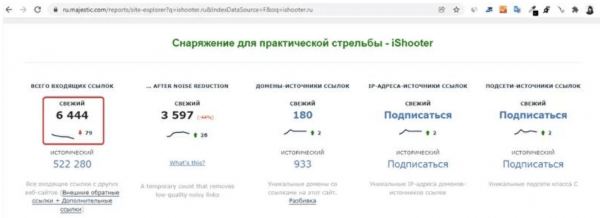

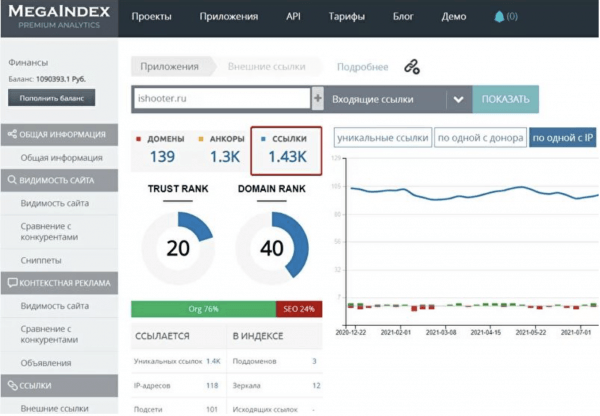

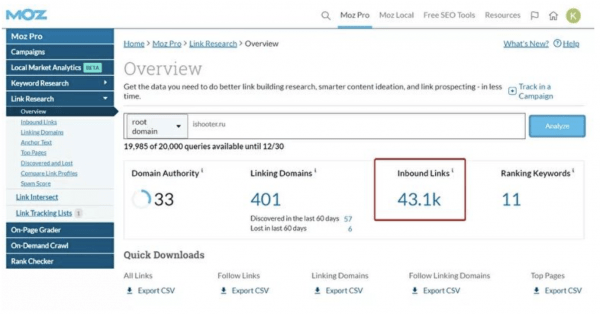

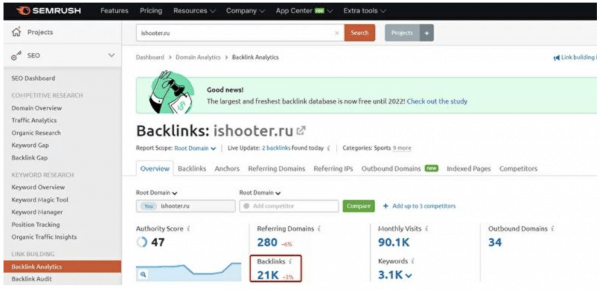

Приведем данные по количеству найденных сервисами ссылок для сайта ishooter.ru:

- MOZ – 43100

- Semrush – 21228

- Ahfers – 15058

- Majestic – 6444

- MegaIndex – 4100

- Serpstat – 3570

- Google Search Console

Ahrefs

Serpstat

Majestic

MegaIndex

MOZ

Semrush

Google Search Console

Как видим, количество найденных ссылок значительно отличается от сервиса к сервису. Чтобы получить 80+% информации по беклинкам SEO-специалистам приходится использовать несколько инструментов одновременно.

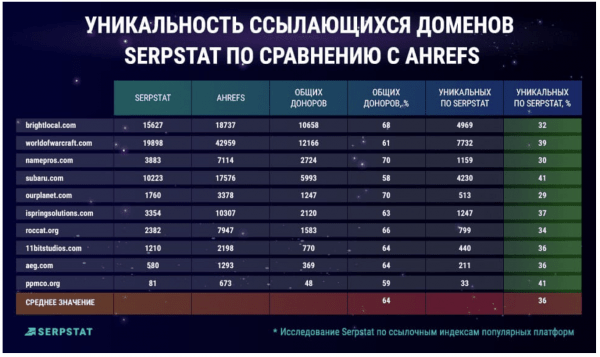

Уникальность данных по ссылкам

Еще один параметр, который использовался Serpstat для оценки, – это уникальность данных. Он является одним из основополагающих при выборе сервиса для анализа ссылок и определяется как процент ссылающихся сайтов-доноров, которые отсутствуют в отчетах конкурентов.

Оценка проводилась с учетом данных для указанных сервисов по 10 разным сайтам. В конечном отчете компания сравнила полученные показатели по Serpstat и конкурирующим платформам.

В среднем, Serpstat имеет до 60% ссылающихся сайтов, присутствующих в отчетах конкурентов, и около 40% уникальных доменов, которые отсутствуют в результатах аналогичных сервисов.

Serpstat vs Ahrefs

Serpstat vs Semrush

Serpstat vs MOZ

Чтобы получить максимально полную картину для анализа компания рекомендует использовать инструменты Sepstat, которые обеспечивают высокий процент уникальных данных, в сочетании с другими сервисами.

В заключение

Чтобы получить полную картину по обратным ссылкам, seo-специалисты по-прежнему продолжают комбинировать различные сервисы и платформы, так как ни один инструмент на сегодняшний день не обеспечивает 100% точной информации, а их алгоритмы сбора данных существенно различаются.

Тем не менее, эксперты сходятся во мнении, что качество беклинков имеет основополагающую роль. Как бы большие цифры не тешили самолюбие маркетолога, их значение может быть слишком оторвано от реальности.

Если вы выбираете сервис для анализа ссылок, то исследование, проведенное компанией Serpstat, предлагает полезную информацию для взвешенного выбора.

Перейти к полному варианту исследования

Источник: searchengines.ru