На онлайн-конференции «SEO без воды» Юрий Хаит (Bitkey) рассказал о «Современных стратегиях работы со ссылками». Юрий объяснил, почему ссылки не работают, верить ли показателям DR/UR и TF/CF и как ускорить индексацию доноров. Обо всем этом читайте в нашем обзоре или смотрите видео.

Видеозапись доклада вы найдете в конце статьи.

Почему ссылки не работают

Для проведения ссылочного анализа, как правило, используются следующие инструменты:

- Ahrefs

- Majestic

- Google Search Console

- Яндекс.Вебмастер

- SEMrush

- Serpstat

- MegaIndex

Для удобства анализа Юрий использует программу Linkbox. Она позволяет работать со ссылками, которые добывают из Ahrefs, Search Console и др. источников, и проверять их работоспособность.

По словам докладчика, типичная проблема, с которой сталкиваются специалисты, анализируя ссылки из Ahrefs – большинство из них не существует в принципе.

Как это происходит: взяли один проект, из которого выгрузили 1411 ссылок. Из них только 719 оказалось проиндексировано. 420 – не в индексе. Остальные отдают недействительный код ответа, либо не проверены.

Глобальная картина со ссылками из Ahrefs: только 1/10 выгружаемых ссылок работают.

Это связано с тем, что с донора идет более 1 ссылки на станицу-акцептор: одна из них каноническая, одна нет, но фактически это одна и та же ссылка. Часто ссылки нет на месте (удалена вебмастером). Или ссылка находится на сайте, которого уже нет.

5 основных причин, почему ссылки не работают:

- ссылки нет;

- одновременно донор noindex + ссылка nofollow;

- донор 404;

- дубль;

- страница низкого качества.

Юрий привел пример анализа ссылок по двум проектам: своего под NDA (на графике показан оранжевым цветом) и конкурента (голубой цвет).

Анализ ссылочной массы своего проекта (ndaproject4) и сайта конкурента (moving.com)

Ссылочные массы сайтов похожи, но конкурент находится в ТОПе.

Поэтому работу начали с того, что почистили дубли – страницы, которые имеют тот же самый контент, но уже с другим урлом.

При анализе мест размещения ссылок оказалось, что у своего проекта многих ссылок нет. Большинство из них не в индексе. Далее сравнили, какие ссылки с doFollow, какие нет.

В итоге оказалось, что ссылок у своего проекта существенно меньше, чем у конкурента.

Как видят ссылки Ahrefs, Google Search Console и Яндекс.Вебмастер

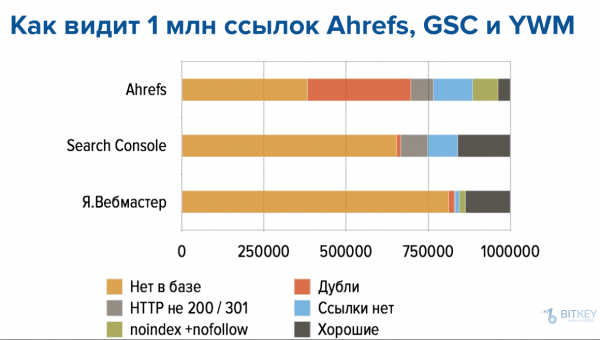

Далее, чтобы выяснить, какому источнику можно верить, взяли больший объем – 1 млн обратных ссылок на проекты в Рунете – и сравнили, что по ним видит Ahrefs, Search Console и Яндекс.Вебмастер.

Пример анализа ссылок в анализаторах: Ahrefs, Google Search Console и Я.Вебмастер

На графике серый прямоугольник в конце – это так называемые хорошие ссылки.

Оказалось, что большая часть ссылок, которые изъяты из Ahrefs – мусорные, в них много дублей, страниц, которые отдают ответ, отличный от 200, хороших ссылок остаётся 10%.

У Google Search Console результат получше, хороших ссылок 20%.

У Яндекс.Вебмастера в целом неплохо, но туда попадает очень мало ссылок. Возможно потому, что Яндекс не индексирует отдельные доменные зоны.

Итог Ahrefs vs Google Search Console:

Полнота Ahrefs – 62%, высокая дублицированность. В Ahrefs много ссылок с неиндексируемых страниц, обёрнутых в nofollow.

Google Search Console содержит 24% ссылок, которые отдают ответ 404. И еще столько же ссылок, которых уже нет.

Если ссылка не попала в Search Console, значит с ней что-то не так, хорошая ссылка всегда попадет в GSC.

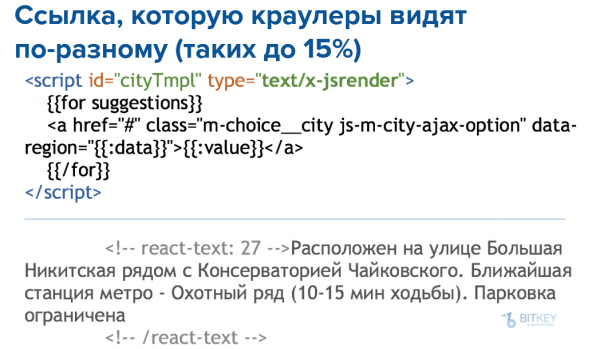

Примечание: Почему анализаторы отдают разные данные? Связано с тем, что разные роботы-краулеры по-разному считывают AJAX. Например, такую штуку как React умеет читать только Яндекс, соответственно данные по ссылкам, которые есть на странице, применяющей React, есть только в Яндекс.Вебмастере. Если там нет пререндера, то Google эту ссылку не увидит.

Пример, как краулеры видят ссылки

Как видят ссылки Majestic и Serpstat

Другой важный инструмент в работе со ссылками – Majestic, однако его API стоит $400 в месяц. Majestic использует параметры CF/TF, которые говорят о том, насколько хорошо у сайта донора со ссылками:

- Citation Flow (CF) показывает, сколько всего ссылок есть на страницу/на сайт, по данным Majestic.

- Trast Flow (TF) Majestic считает по своей базе хороших сайтов, насколько часто они ссылаются на ваш сайт.

При сравнении данных Ahrefs и Majestic по одному и тому же сайту получены следующие результаты:

- Ahrefs увидел 5 млн обратных ссылок.

- Majestic видит только 2 млн.

Это происходит потому, что в Majestic попадает намного меньше дублей. Получаем больше чистых данных.

Это очень неплохой показатель, но там нет свежих данных. Если вы реализовали стратегию крауд-маркетинга в прошлом месяце, то не сможете ее проанализировать. Данные обновляются очень редко, в лучшем случае 1 раз в месяц.

Итог Ahrefs vs Majestic:

- Дубли: в Majestic их почти нет;

- Полнота: в Majestic попадает до 86% ссылок (у Ahrefs в среднем – 62%);

- Свежих данных нет ни там, ни там, что невозможно применять при линкбилдинге.

Еще один инструмент Serpstat. На данный момент в нем почти триллион (952 млрд) ссылок по 168 миллионам доменов. Каждый день Serpstatbot добавляет 2 млрд новых ссылок и обходит 2,5 миллиона доменов в день.

Serpstat считает ссылки с поддоменов внешними. Если на сайте есть линковка между поддоменами, он показывает для вашего домена, что это внешние ссылки.

У Serpstat небольшое количество API-лимитов, они тарифицируют именно ответы, а не запросы, которые вы делаете, получается, чтобы собрать данные по ссылкам нужно затратить много ресурсов. Данные там достаточно грязные с ними трудно работать.

Важные наблюдения

Ссылки с высоким Trust flow – меньше 1 млн хорошо коррелируют с положительной динамикой позиций.

В YMYL-тематиках (медицина, юриспруденция, финансы), где контент может повлиять на жизнь и здоровье людей, Google стремится давать правдивые ответы, поэтому использует такие параметры, как авторитетность ресурса. Для всех остальных (не-YMYL) тематик оказывается, что низкокачественные ссылки работают так же, как и высококачественные.

Cсылки, которые дают Advodka, Keys.so pr-cy и другие анализаторы НЕ надо закрывать в disavow. Часть из них – хорошие. Ими можно бустить страницы доноров.

Как индексировать ссылки

Раньше проставив ссылку на страницу донора, мы сразу отправляли ее в addURL. Теперь инструмент от Google работать перестал.

- Twitter: не работает. Индексируется менее 3% ссылок.

- Для ссылок Tier2, Tier3: годятся любые инструменты типа Xrumer, Senuke Xcr и т.д., но избавляться от footprint-ов дорого для целей индексации.

- Дорвеи: хороший метод, но дорого и одни те же домены нельзя использовать для индексации постоянно, т.к. они быстро попадают в бан.

- 301: http://linkbox.pro/ru/google-addurl (несколько трастовых сайтов без футпринтов – добавляем URL с редиректом в GSC и отправляем на индексацию).

Хотя это странно обходить Google страницы, которые отдают 301, но робот обходит эту страницу, так повышается вероятность добавления ее в поиск. Получается классный инструмент. НО у нас нет доступа к самим донорам, откуда пришел редирект.

Выводы

- Качественные метрики ссылок меньше коррелируют с позициями, чем количественные.

- Инструменты ссылочного анализа, основанные на big data, содержат много неактуальных, грязных данных и не подходят для анализа работы линкбилдеров.

- Проиндексировать свои ссылки дешевле, чем купить новые.

Видеозапись доклада

Презентация доклада доступна по ссылке.

Источник: seonews.ru